Analyzer Online

Le making of

Auteurs : Dominique Saubion & Luc Coiffier

Temps de lecture : 8 min

la généralisation du « Cloud Computing ». Dans ce contexte, les comportements numériques ont évolué dans le cadre personnel et professionnel. La population s’est habituée à accéder à tout, partout de façon simple et rapide.

Nos solutions Géomarketing se sont adaptées à ce changement, mais quels sont les avantages réels de cette digitalisation ?

RÉTROSPECTIVE

RÉTROSPECTIVE

L'ère du spécifique

Dans les années 2000, l’accès aux solutions géomarketing s’est généralisés. Les entreprises possédant un réseau de points de vente cherchaient à fiabiliser leurs méthodes d’études et à mieux comprendre les particularités locales de leur parc.

Les cahiers des charges étaient complexes, car ces solutions avaient pour objectif de répondre à un grand nombre de critères.

Exercice périlleux. Si l’on considère que les besoins pouvaient varier considérablement en fonction :

- Des directions concernées :

- • Marketing ou Études

- • Expansion

- • Distribution ou exploitation

- Des profils utilisateurs :

- • Technique (data analystes, cartographes, informaticiens)

- • Études (chargés d’études, chefs de projets, responsables média)

- • Métier (développeurs, chargés de communication, chargés d’affaires, directeurs de points de vente)

- Des secteurs d’activité concernés :

- • Les réseaux de services (banques, assurances, téléphonie mobile…)

- • Les réseaux de commerçants (grandes surfaces alimentaires, spécialisées, commerces de proximité…)

- • Les équipes commerciales des industriels

Les outils bureautiques ou « client lourd » – nom très évocateur… – , essayaient de répondre à tous ces besoins ; et ce, à grand renfort de fonctionnalités spécifiques, d’algorithmes toujours plus complexes et d’ergonomies ajustées à la demande.

Ces solutions, aussi complexes soient-elles, permettaient de mieux comprendre l’Écosystème de son réseau de points de vente, de réaliser des études « Ad ‘hoc » grâce aux nombreuses données accessibles et de créer de nouveaux indicateurs si besoin.

Mais leur intérêt premier était d’apporter une automatisation des études et des process afin d’harmoniser les livrables, quel qu’en soit le producteur.

Le revers de la médaille

L’organisation interne nécessitait d’avoir des « spécialistes » de la manipulation de données, soit pour réaliser eux-mêmes les études, soit pour encadrer des profils moins techniques dans l’utilisation des solutions.

Les principaux utilisateurs étaient généralement sédentaires, car jusqu’au début des années 2010, les données étaient stockées principalement sur des serveurs locaux accessibles uniquement via les réseaux internes aux entreprises.

Le coût d’entrée de l’utilisation de ces solutions était important. En effet, ces outils nécessitaient des formations complètes pour pouvoir les utiliser de façon optimale.

Mettre à jour les données, intégrer les nouvelles fonctionnalités… Ces opérations étaient longues et coûteuses. L’hébergement des solutions et des données par le client lui-même, rendait les choses complexes.

Finalement, les évolutions technologiques de la moitié des années 2000 et du début des années 2010 ont changé la donne.

LA RÉVOLUTION DU NUMÉRIQUE

LA RÉVOLUTION DU NUMÉRIQUE

L'ère du "Cloud Computing"

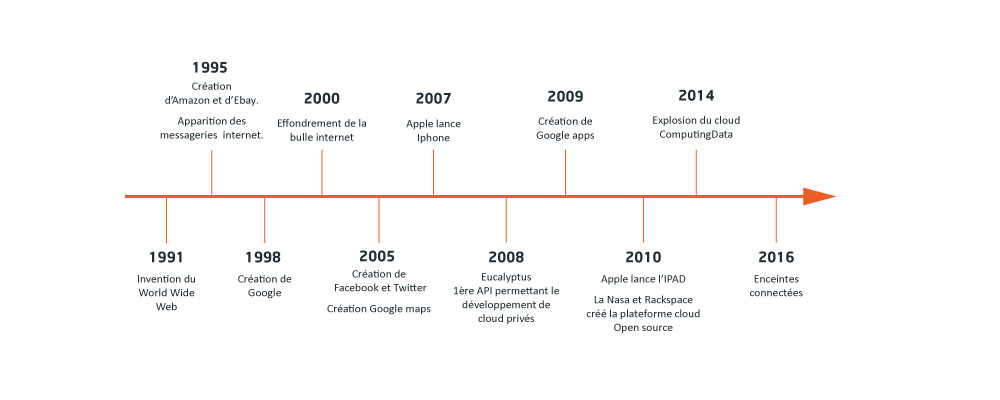

Le changement de millénaire, s’il n’a pas provoqué le bug attendu, a révolutionné l’usage du numérique, et ce, même s’il a commencé par l’éclatement de la bulle internet.

Les innovations qui ont jalonné les 15 premières années ont profondément changé les comportements des individus dans la sphère privée et dans la sphère professionnelle :

- Réseaux sociaux

- Smartphones

- Tablettes numériques

- Enceintes connectées…

Ces innovations ont rencontré un large public, et en particulier les plus jeunes – les « millénial » – et la génération suivante – les « natifs numériques » -. Les premiers ont appris à utiliser toutes ces nouvelles technologies à l’âge adulte, les seconds sont nés déjà connectés.

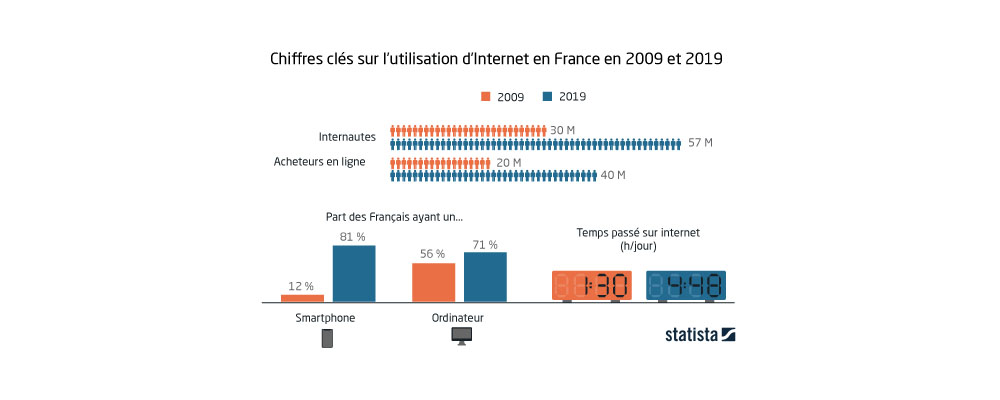

En France, par exemple, l’utilisation d’internet a doublé en 10 ans, l’équipement en smartphone a été multiplié par 8 et le temps passé sur internet a plus que triplé.

L’augmentation massive du nombre d’internautes et du volume de données échangées, a permis, l’émergence du Cloud Computing et de l’externalisation de l’hébergement des données et des solutions informatiques.

Dès lors, l’évolution des plateformes géomarketing bureautique vers le format web, était nécessaire.

Les solutions actuelles

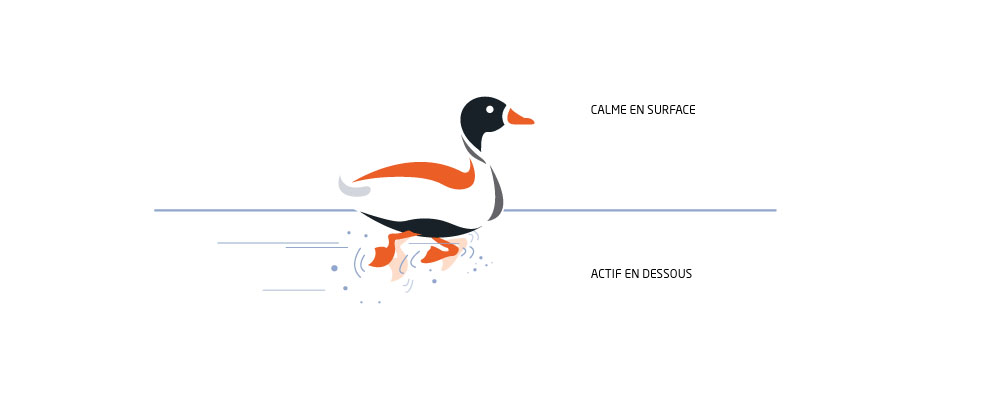

Les solutions géomarketing se sont adaptées à l’ère du digital, avec des interfaces beaucoup plus ergonomiques, beaucoup plus simples d’utilisation.

Aujourd’hui, l’extérieur devient le bureau !

Vous pouvez commencer une étude – avec votre téléphone ou votre tablette – en déplacement sur le terrain, dans un magasin, sur un chantier et la finir de retour au bureau avec votre ordinateur.

Vous pouvez contribuer à enrichir vos bases de données.

En allant sur le terrain, vous voyez que vos points de vente sont mal géolocalisés, vous pouvez les déplacer et tout le monde bénéficiera de ce que vous avez fait.

Ces solutions sont maintenant à la portée de tous : techniciens et utilisateurs métiers, sans compétences informatiques ou traitement data particulières.

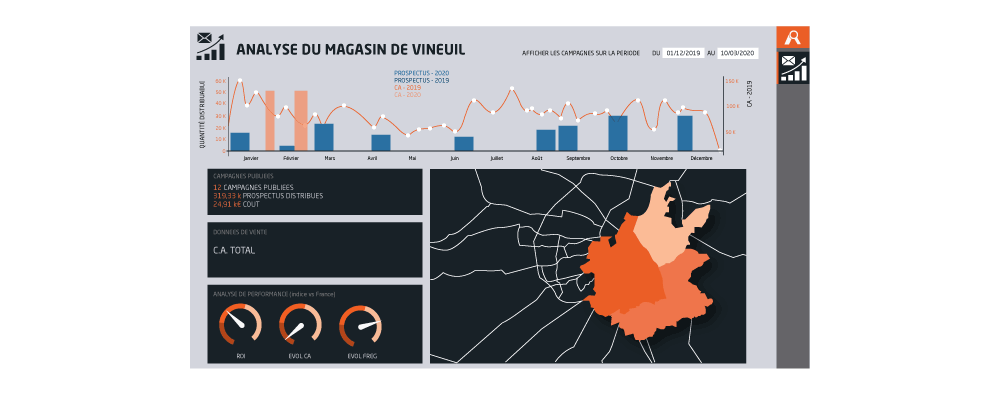

Du directeur de point de vente au directeur de réseau, du développement ou de la communication, chacun peut y trouver son compte. Chaque profil peut accéder à une interface plus ou moins complexe selon ses besoins. La technologie est la même, mais les écrans et niveaux d’analyse disponibles sont différents.

Regardons un exemple, le niveau d’information visible, des indicateurs visualisables, n’est pas le même, selon le profil connecté.

Informations utiles pour le point de vente

- Sa zone

- Son écosystème (démographie – concurrence)

- Sa performance – en comparaison des points de vente qui lui ressemble – au local si la donnée est disponible, sinon au global : (fréquentation – panier moyen)

Informations utiles pour le responsable région :

- Sa région

- Ses points de vente

En bref, tout est possible, enfin presque. La seule question à garder à l’esprit est : en ai-je vraiment besoin ? Car si les interfaces semblent de plus en plus simples à l’usage, c’est loin d’être le cas d’un point de vue technologique…

C'est pourtant simple.

C'est pourtant simple.

Ou plutôt cela devrait l’être.

L’équation à résoudre est la suivante :

Un seul coup d’œil doit permettre de visualiser les éléments clés.

Un seul clic doit permettre d’accéder à l’information importante.

Et il faut aussi pouvoir entrer dans le détail quand cela est nécessaire, disposer de fonctionnalités avancées – de façon naturelle – et disposer d’une interface web moderne fonctionnant aussi bien sur smartphone que sur tablette.

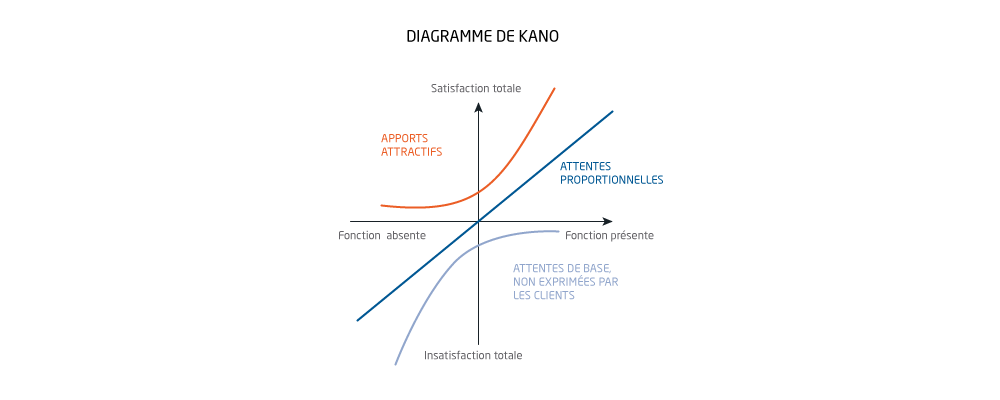

L’ajout de fonctionnalités complexifie la mécanique. En effet, ajouter un bouton dans un coin pour accéder à une nouvelle fonctionnalité – ce qui semble une bonne idée au départ… – peut créer une incohérence fonctionnelle dans l’outil et perturber l’utilisateur.

Toutefois, l’absence de fonctionnalités clés rend l’application sans intérêt, et au contraire, le trop-plein de fonctionnalités rend l’application inutilisable ou du moins, complexe à maîtriser. Prenons l’exemple de Photoshop, et vous aurez une idée d’une application certes riche, mais incroyablement complexe à maîtriser.

Au départ, les cahiers des charges pouvaient ressembler à certains appels d’offre où l’urgent côtoie l’accessoire…

Pour autant, résoudre cette équation n’est pas comparable à résoudre une énigme insoluble : tous nos clients ont des besoins et des priorités remarquablement similaires.

Il nous a juste fallu quelques années pour les identifier et les qualifier, parfois nous pouvons être un peu lents.

Finalement, s’il paraît simple de construire une usine à gaz, il est, au contraire, extrêmement compliqué de développer une application fonctionnellement riche et simple à utiliser.

Ainsi, nous avons hiérarchisé les fonctionnalités et privilégié la cohérence et l’efficacité de l’interface à l’ajout anarchique de fonctionnalités sans logique fonctionnelle globale.

Cette hiérarchisation nous a, également, permis d’identifier l’essentiel et de le séparer de l’accessoire. En effet, nous avons apporté un effort particulier à rendre l’essentiel réactif – la performance – et simple l’utilisation – l’efficacité -.

L’interface utilisateur réagit immédiatement, les rapports sont générés en quelques secondes, les opérations longues sont fluides et sont accompagné d’informations visuelles permettant d’en suivre l’avancement…

Ce sont des dizaines d’années d’expérience cumulées en matière de design d’interface utilisateur, qui sont intégrées dans nos produits.

Les génériques sont aussi efficaces

Les génériques sont aussi efficaces

Il faut savoir que tous nos clients bénéficient de cette plateforme fonctionnelle générique et évolutive.

Asterop, qui est éditeur de logiciel depuis sa création, propose donc un seul logiciel, une seule technologie pour tous nos clients.

Cela signifie aussi, que tous nos clients bénéficient des mises à jour régulières : corrections de bugs, l’ajout de nouvelles fonctionnalités ou encore, l’amélioration de fonctionnalités existantes.

Par exemple, en 2019, nous avons ajouté une fonctionnalité standard permettant de comparer plusieurs projets ou points de vente d’un seul coup d’œil. Les clients sous maintenance ont bénéficié de la nouvelle fonctionnalité dans le cadre de ces maintenances.

L’année précédente, c’est cette fois, des fonctionnalités permettant de qualifier les projets qui ont été ajoutées à la plateforme générique. Dont tous nos clients ont bénéficié.

Pour 2020, d’autres nouveautés sont prévues… Mais il est encore un peu prématuré d’en parler. Toutefois, si vous êtes client, vous serez contacté dans le courant du quatrième trimestre pour une présentation des nouvelles fonctionnalités dont vous bénéficierez automatiquement d’ici la fin de l’année.

Cet effort et la généricité (ou programmation générique) des fonctionnalités, s’appliquent également à tous les autres aspects de nos solutions. Ainsi, le contenu et la présentation de nos rapports sont issus de notre expérience et des échanges que nous avons eus avec nos clients au cours des dix dernières années. Aujourd’hui, Et vous en bénéficiez directement.

De même, les KPI retenus, les données pertinentes retenues et la façon de les présenter sont le résultat de centaines d’heures de réunion et de dizaines d’années de recherche intensive.

Le temps du logiciel unique pour tous est pourtant révolu. Maintenant, chaque logiciel doit être personnalisé pour s’adapter à chaque utilisateur.

Il y a dix ans, cette capacité de personnalisation passait systématiquement par le développement d’une application spécifique pour chaque client.

Elle engendrait un cycle qui ne faisait que se répéter : l’application créée était figée, elle ne bénéficiait pas ou peu des nouvelles fonctionnalités et, au bout de quelques années, il fallait se rendre à l’évidence : l’application ne correspondait plus aux besoins et elle était devenu obsolète. Donc, il fallait en développer une nouvelle en repartant de zéro, avec tous les coûts que cela supposait.

Pour un éditeur, ce cycle et cette approche « application jetable », ne permettaientt pas de construire et d’enrichir une base pérenne de fonctionnalités.

Il nous a fallu plusieurs années et la stabilisation des standards du web pour trouver la solution à ce problème.

D’une part, nous avons développé une plateforme fonctionnelle générique en utilisant toutes les fonctionnalités disponibles dans le cœur de notre technologie depuis sa création en 1999. Et oui, pour répondre à cette question, des lignes de codes écrites en 1999, sont encore utilisées dans près des 10 millions de lignes de code de notre technologie.

D’autre part, nous avons systématisé l’identification des zones de personnalisation pour chacune de nos fonctionnalités.

Ainsi, un socle technologique commun à toutes nos solutions est mis à disposition de tous nos clients. Il inclut des dizaines de fonctionnalités génériques : gestion des projets, gestion du parc, approche collaborative, tableau de bord interactif, gestion multienseigne, gestion des zones d’exclusion, scoring des zones et des emplacements, génération de rapports PDF et PPT…

Mais pour chaque fonctionnalité générique, un ou plusieurs points de personnalisation ont été identifiés et permettent à chaque client de profiter d’une interface et d’une expérience totalement unique et taillée sur mesure.

Depuis deux décennies les technologies ont évolué et pourtant les problématiques sont globalement les mêmes : analyser un emplacement, décider d’une stratégie, disposer des KPI pertinents…

Depuis deux décennies nous exploitons l’ensemble de la puissance mise à notre disposition, et celle-ci double tous les 18 mois : les données sont de plus en plus riches, les algorithmes de plus en plus complexes, les capteurs de plus en plus nombreux…

Ainsi l’intelligence artificielle a fait son entrée dans notre technologie en 2010, boostée par les puissances de calcul disponible dans le Cloud. De même le Big Data est au cœur de notre métier et nous le pratiquons depuis… toujours.

De grands mots donc, Intelligence Artificielle, Big Data, Cloud, mais qui n’ont de sens que si les résultats sont présentés de façon digeste aux utilisateurs.

Cela a été notre enjeu depuis notre création, et il y a peu de doute que cela le reste pour les années à venir tant les nouveaux supports présentent également de nouveaux défis.

À propos de nos auteurs :

Luc Coiffier, Directeur Général d’Asterop

Luc Coiffier est co-fondateur et Directeur Général Délégué d’Asterop. Il est particulièrement en charge des aspects technologique, data et méthodologique. Issu d’une formation mathématique & informatique, il a également été Directeur R&D et créateur d’un SIG français majeur.

Et

Dominique Saubion, Directrice du Pôle Conseil Asterop

Spécialiste en pilotage de projets d’optimisation de la performance, Dominique Saubion possède plus de 10 ans d’expérience en conseil en géomarketing décisionnel. Avant cela, elle a travaillé 20 ans au sein d’un grand groupe de distribution français, en management de projets d’expansion et d’amélioration de l’offre en magasin.

Leader de l’optimisation des réseaux de points de vente, Asterop crée des solutions personnalisées et propose des données de qualité pour fiabiliser vos décisions d’implantation et de ciblage.

Intéressé ? Nos équipes commerciales répondent à vos questions